ChatGPT ist ein großes Sprachmodell, das von OpenAI entwickelt wurde. Es wurde trainiert, um menschenähnliche Konversationen durch natürliche Sprachverarbeitung zu führen und Antworten auf eine Vielzahl von Fragen zu geben. ChatGPT verwendet ein neuronales Netzwerk, um auf Fragen zu antworten, indem es auf eine riesige Menge von Texten zugreift und dabei versucht, den Kontext und die Bedeutung von Wörtern und Sätzen zu verstehen. Ich habe mich auch eingehend mit Risiken und Problemen bei der Verwendung von Chat GPT befasst, was ich übrigens allen Menschen empfehle, die sich mit Künstlicher Intelligenz beschäftigen oder diese regelmäßig nutzen.

Dieser Artikel ist teilweise mit Hilfe von ChatGPT erstellt

Ich gebe es zu, diesen Artikel habe ich mit Hilfe von ChatGPT erstellt bzw. erstellen lassen. Den einleitenden Absatz habe ich mir vom Chatbot generieren lassen:

Auf den ersten Blick ist das eine Revolution des Content Marketings. Perfekte Texte für Blog- und Fachartikel werden in Sekundenschnelle ausgeworfen. Doch ist das wirklich so klug, sich die mühevolle Denk- und Recherchearbeit durch den Einsatz künstlicher Intelligenz zu ersparen? Dies ist sicherlich künftig ein „diskutierenswertes“ Thema. Doch in diesem Artikel geht es nicht um den sinnvollen und moralischen Anspruch dieser Entwicklung, sondern darum diese künstliche Intelligenz rein fiktiv als gleichwertiges Wesen anzuerkennen und seine Logik, sein Wissen und seine Bezugsquellen zu analysieren. In diesem Artikel geht es um einen Test, den ich mit ChatGPT gemacht habe.

ChatGPT im Härtetest

Nachdem mir ChatGPT bei beruflichen Herausforderungen und Spezialthemen extrem wertvolle Informationen geliefert hat (wofür ich im übrigen sehr dankbar bin), habe ich mir überlegt, den Chatbot zu komplexen gesellschaftlichen Themen zu befragen, die eventuell ein kleines bisschen kontrovärs sein könnten. Ich habe mir das Thema „Grundwasserversorgung in Österreich“ ausgesucht. Dieses Thema hat einerseits seine vollständige Berechtigung, wird aber auf der anderen Seite (noch) nicht als heftig polarisierendes Thema in der Gesellschaft aufgefasst. Als habe ich ChatGPT gefragt: „Warum verliert Östereich so viel Grundwasser?“

Ich weiß, dass meine Art der Fragestellung schon impliziert, dass Österreich sowieso Grundwasser verliert (der gleiche Trick, den Moderatoren im TV anwenden, wenn sie das Thema gezielt lenken wollen), aber ChatGPT hat mein Framing angenommen und mir vier Gründe genannt, warum das so ist (siehe Abbildung). Okay, somit steht fest, dass ein Verlust unseres Grundwassers keine Einbildung oder kein Tatbestand von Fakenews ist.

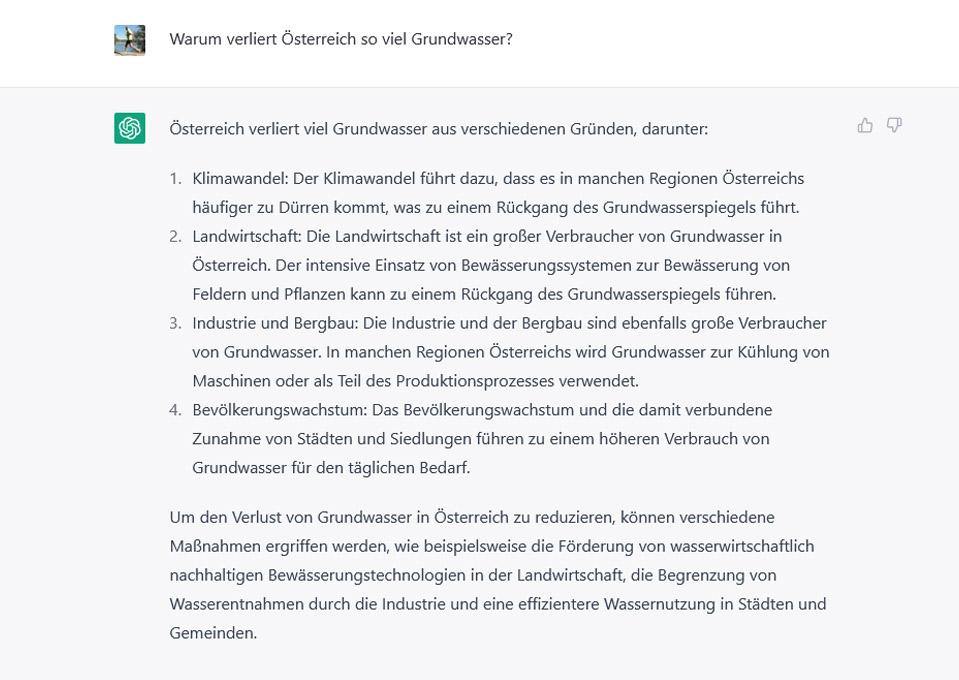

Nun liegt es auf der Hand, dass es mich interessiert, wie viel Grundwasser Österreich verliert, also frage ich den „allwissenden“ Chatbot nach seiner Expertise:

Wie im Chatverlauf zu sehen ist, bezieht sich der Chatbot auf eine Studie. Er führt aber die Quelle der Studie nicht an. Seiner erste Antwort darauf lässt den Rückschluss zu, dass die öffentliche Wasserversorgung und die industrielle / landwirtschaftliche Nutzung die Hauptgründe für den Grundwasserverlust sind.

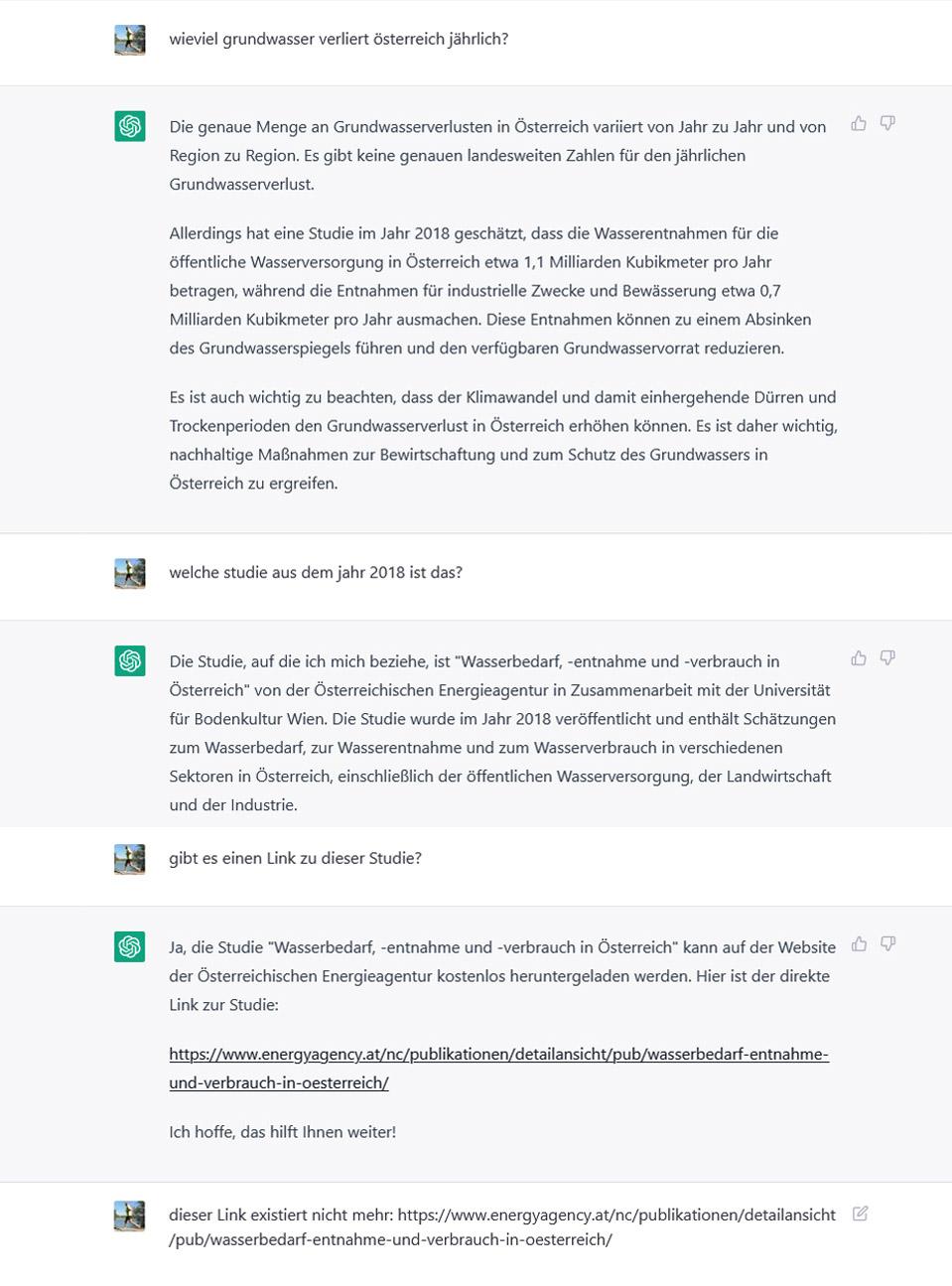

Auf meine Frage, um welche Studie es sich dabei handelt, sendet er mir einen Link zu der auf eine 404-Seite leitet.

Nun zeigt der Chatbot ein Verhalten, welches auf der einen Seite sehr diplomatisch damit umgeht, aber auf der anderen Seite auf massive Schwachstellen im Umgang mit gewissen Informationen aufzeigt:

Hier teilt mit ChatGPT sogar mit, dass er diese Information / diesen defekten Link fälschlicherweise so angenommen hat. Es ist erstaunlich wie „menschlich“ diese Maschine plötzlich reagiert und meint „er habe etwas angenommen“. Wie kann man einen Studie und einen Link sich lediglich einbilden / annehmen? Ehrlich wäre es gewesen, wenn der ChatGPT geantwortet hätte, dass aus nicht bekannten Gründen die „Energyagency“ die Studie entfernt hat. Warum sie das gemacht hat, kann und muss der Chatbot nicht wissen. Aber der Test geht weiter:

Nun wird es langsam peinlich. ChatGPT schlägt mir immer wieder Verlinkungen zu offiziellen Websites vor, die allesamt nicht funktionieren, wie zum Beispiel: hier (Redirect auf Startseite). Dies erzeugt natürlich einen unangenehmen Beigeschmack und es wird der Eindruck vermittelt, dass bei diesem Thema rund ums Grundwasser versucht wird, Informationen und Studien dazu zu unterschlagen – eine Goldgrube und Nährboden für Verschwörungstheorien.

In der Tat ist es sehr eigenartig, dass keine relevanten und konkreten Aussagen dazu zu finden sind. Natürlich kann es auch sein, dass bei statistik.at und boku.ac.at unprofessionell gearbeitet wird und daher Studien und Kennzahlen spurlos verschwinden. Aber in der Regel werden Quervereise und Revisionen gemacht, wenn studienbasierte Inhalte verändert werden. Für eine lückenlose Nachvollziehbarkeit ist das so auf jeden Fall mehr als mangelhaft.

ChatGPT wird sich die defekten URLs zu den Studien ja auch icht eingebildet haben, wie auch soll das eine Maschine zustande bringen. Daher ist es meiner Auffassung nach klar, dass es diese Verlinkungen in der Vergangenheit wirklich gegeben hat. Ich habe nun auch in Online-Archiven wie Wayback Machine (dort sind 789 Milliarden alte URLs archiviert), Archive today, etc … danach gesucht, bin aber leider nicht fündig geworden.

Nach intensiver Recherchearbeit bin ich zu dem Folgeschluss gekommen, dass ChatGPT sich offensichtlich wirklich geirrt zu haben scheint und damit unter Umständen ein Misstrauen gegen offizielle Informationsdienste auslösen könnte. Dieses Testergebnis zeigt gefährliche Schwachstellen des Systems auf und zeigt, dass hier ein hohes Gefahrenpotenzial für Misstrauen und Konflikte vorhanden ist.

Testergebnis des ChatGPT-Tests

Das Testergebnis des ChatGPT-Tests fällt in diesem Fall nicht so rosig aus, wobei bei oberflächlichen Fragen zur Spezialthemen der Chatbot wirklich eine Geheimwaffe im positivem Sinne sein kann. Was Content Marketing betrifft, so empfiehlt es sich wirklich, auf die Dienste von ChatGPT eher zu verzichten und echte Recherchearbeit zu leisten um solche Missverständnisse, wie in diesem Test gezeigt, zu vermeiden. Abschliessend hat sich ChatGPT bei noch eingehend entschuldigt, leider mit einem weiteren Link, der nicht (mehr) funktioniert. Irgendwie tut mir der arme Chatbot schon fast leid ….